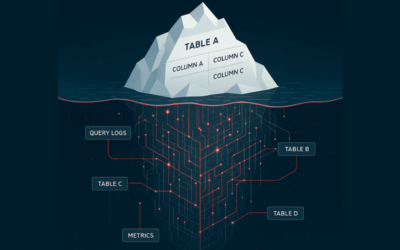

Een goed functionerend AI-model begint niet bij een algoritme, maar bij data die beschikbaar, betrouwbaar, schaalbaar en bruikbaar is. En precies daar komt data engineering om de hoek kijken. Data engineers leggen de fundamenten waarop alles rust: van datacollectie tot validatie, transformatie en opslag. Zij zorgen dat data via pipelines op de juiste manier door het systeem stroomt, geoptimaliseerd voor zowel snelheid als kwaliteit. Vergelijk het met een moderne auto. AI is het zelfrijdende systeem; data engineering is de weg, de infrastructuur, de verkeersborden en het onderhoud.

Zonder solide dataplatform geen bruikbare AI

In de praktijk zie je nog te vaak dat AI-initiatieven op een wankel dataplatform gebouwd worden. Denk aan datasilootjes, handmatig aangeleverde Excel-bestanden of datastructuren die zijn ingericht voor rapportage, niet voor machine learning. Een concreet voorbeeld: een organisatie wil klantgedrag voorspellen op basis van historisch websitegedrag. De ruwe logs worden echter pas elke week handmatig ingelezen. De benodigde datapunten komen uit drie verschillende systemen die elk hun eigen structuur en tijdzones gebruikten.

Resultaat? Voorspellingen die standaard gemiddeld drie dagen achterliepen en in de praktijk dus totaal niet bruikbaar waren. De oplossing lag niet bij het AI-model, maar bij het herontwerpen van de data pipeline: realtime event streaming, tijdsynchronisatie en automatische validatie. Pas toen dat op orde was, kon het model daadwerkelijk waarde toevoegen.

Automatisering faalt zonder robuuste data engineering

Een andere veelvoorkomende valkuil is de schaalbaarheid van dataworkflows. Je start met een proof-of-concept op een afgebakende dataset, en alles werkt prima. Maar zodra je de scope vergroot, of meerdere teams tegelijk aan de data willen trekken, knalt de performance in elkaar. Data engineers weten dat het loont om vanaf het begin na te denken over modulariteit, versioning, data lineage en monitoring. Tools als dbt, Apache Airflow en Delta Lake helpen bij het beheren van complexe data pipelines, terwijl cloudplatforms zoals Snowflake of Google BigQuery schaal en flexibiliteit bieden, mits je ze slim inzet.

Ook binnen automatisering is data engineering cruciaal. RPA-oplossingen of andere workflowtools kunnen processen automatiseren, maar zijn vaak afhankelijk van gestructureerde input. Als die input niet gestandaardiseerd, gecontroleerd en op het juiste moment beschikbaar is, dan automatiseer je in feite een rommelproces. Hier zie je dat data engineering een enabler is van échte end-to-end automatisering. Door bijvoorbeeld te zorgen voor gestroomlijnde data-invoer vanuit API’s, gevalideerde business rules in transformatielagen en continue monitoring van datakwaliteit, maak je automatisering schaalbaar en betrouwbaar.

Data engineering als strategische discipline

Wat opvalt, is dat steeds meer organisaties data engineering niet meer zien als puur een technische laag, maar als een strategische discipline. Dat heeft deels te maken met de opkomst van het modern data stack-concept, waarin tools en platforms modulair samenwerken in de cloud. Maar ook de adoptie van datamesh-principes speelt hierin mee. Domeinen krijgen meer verantwoordelijkheid over hun eigen dataproducten, en daarmee wordt data engineering steeds meer een integraal onderdeel van business teams. Het vraagt om andere skills: naast technische kennis van pipelines en infrastructuur, ook gevoel voor datastructuur, data governance en samenwerking.

De trend is duidelijk: AI en automatisering groeien door, maar alleen bij organisaties die hun datagrondslag serieus nemen. Er is simpelweg geen shortcut naar slimme toepassingen zonder een robuust datafundament. Data engineering is niet het sexy onderdeel van het AI-verhaal, maar wel het onmisbare. Het is het verschil tussen een model dat in een demo werkt, en een toepassing die dag in dag uit waarde levert. Wie dus wil investeren in AI, doet er goed aan eerst zijn data engineering op orde te brengen. Niet alleen als technische noodzaak, maar als strategische keuze.