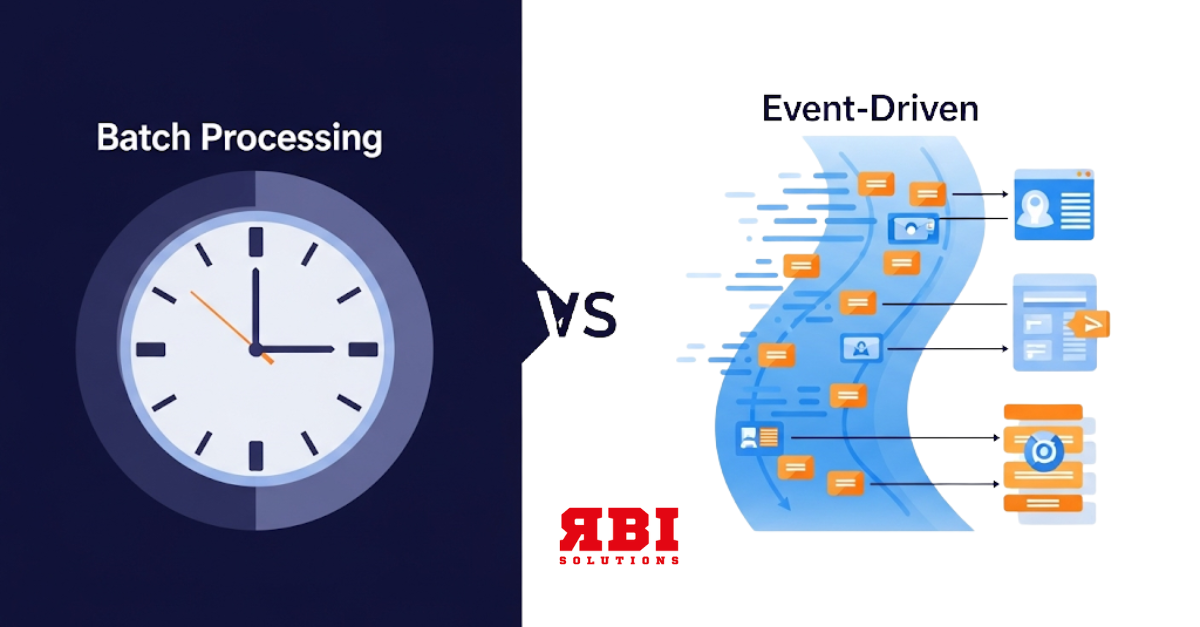

Van batch naar event: waarom we moeten bewegen

Traditioneel verwerken veel organisaties hun data in batches. Denk aan een datateam dat elke ochtend verse rapportages en verantwoordingslijsten levert op basis van data die ‘s nachts is ingeladen uit verschillende bronsystemen. Dit werkt, tot op zekere hoogte. Maar in een tijd waarin klanten realtime updates verwachten, systemen continu met elkaar communiceren en beslissingen steeds sneller genomen moeten worden, begint de batch-benadering te piepen en te kraken.

Een klassiek voorbeeld vinden we binnen de klantenservice. Stel je voor: een klant belt met een klacht over een levering. Ondertussen is de retourzending van datzelfde product al onderweg, maar die informatie zit nog opgesloten in een systeem dat pas ’s nachts wordt gesynchroniseerd met het CRM. Het gevolg: de klantenservicemedewerker ziet verouderde data, biedt verkeerde oplossingen aan en de klant raakt gefrustreerd door tegenstrijdige informatie.

Met een event-driven architectuur zou elke stap in dat retourproces direct als event beschikbaar zijn, van het aanmelden van een retour tot het scannen van het pakket in het distributiecentrum. De medewerkers beschikken zo over realtime inzicht in wat er speelt, wat resulteert in snellere, correctere hulp en een veel betere klantbeleving. De data stroomt hier niet meer via tijdsvensters, maar volgt het pad van de interactie zelf.

Wat is een event-driven data architectuur precies?

Een event-driven architectuur is gebaseerd op het idee dat systemen reageren op gebeurtenissen, oftewel ‘events’. Een event kan van alles zijn: een nieuwe transactie, een wijziging in klantgegevens, een foutmelding of zelfs een sensor die een waarde doorstuurt. In plaats van data periodiek op te halen of te pushen, publiceert een systeem een event zodra er iets relevants gebeurt. Andere systemen (of data pipelines) die geïnteresseerd zijn in dat event kunnen daarop abonneren en meteen reageren.

Deze manier van werken creëert een veel dynamischer datalandschap, waarin de afhankelijkheden tussen systemen minder strak zijn en de verwerkingssnelheid drastisch toeneemt. Systemen zoals Apache Kafka, Pulsar, AWS Kinesis en Azure Event Hubs spelen hier een sleutelrol: ze fungeren als centrale event brokers die zorgen voor schaalbare, betrouwbare en snelle eventdistributie.

De technische onderbouwing: hoe werkt het onder de motorkap?

In een event-driven architectuur zijn drie componenten cruciaal: producers, brokers en consumers.

- De producer genereert een event, bijvoorbeeld een API die een bestelling plaatst.

- De broker ontvangt het event en bewaart het op een robuuste manier, klaar om verspreid te worden. Apache Kafka is hier waarschijnlijk het meest bekende voorbeeld van. Kafka zorgt ervoor dat events gelogd, opgeslagen en eventueel later opnieuw afgespeeld kunnen worden.

- De consumer luistert naar de broker en verwerkt het event zodra het beschikbaar is. Dit kan een data pipeline zijn die het event opslaat in een datalake, of een analytics engine die het event verrijkt en gebruikt voor dashboards of machine learning.

Tools zoals dbt Cloud, Airbyte, Fivetran en Dagster bewegen mee in deze richting en bieden steeds meer ondersteuning voor event-gedreven architecturen. Ze integreren met streamingdiensten of ondersteunen hybride vormen waarin batch en event-driven combineren.

Uitdagingen en valkuilen: het is niet alleen maar winst

Hoewel de voordelen overtuigend zijn, is de overstap naar een event-driven architectuur niet zonder uitdagingen. Ten eerste vraagt het een andere manier van denken. Data is niet langer iets wat je op gezette tijden ‘ophaalt’, maar iets dat zich continu aandient. Dit vereist herziening van hoe pipelines worden ontworpen, getest en gemonitord.

Daarnaast is data-consistentie een heet hangijzer. Hoe zorg je ervoor dat events in de juiste volgorde worden verwerkt, vooral wanneer systemen veranderen? En hoe voorkom je dat dubbele events leiden tot foutieve analyses of acties?

Een andere uitdaging is governance. In een omgeving waarin events real-time verwerkt worden, moet je goed nadenken over metadata, lineage en toegangscontrole. Tools zoals Apache Atlas of OpenLineage kunnen hierbij helpen, maar vragen om volwassen implementatie en een sterke basis in Data Governance.

Tot slot is er de culturele component: niet elk team is klaar voor de snelheid en verantwoordelijkheid die met een event-driven aanpak gepaard gaat. Het vraagt om cross-functionele samenwerking, discipline en een sterke focus op observability.

Best practices en trends: hoe pak je het slim aan?

Wie de overstap wil maken, doet er goed aan om klein te beginnen. Kies één proces waar realtime voordelen evident zijn; denk aan klantinteractie, incidentmonitoring of voorraadbeheer en bouw daaromheen een pilot. Maak gebruik van bestaande event brokers, zoals Kafka (open-source of via Confluent Cloud), en gebruik frameworks als Kafka Streams of Flink voor verwerking. Richt observability direct goed in: tools zoals Grafana, Prometheus of OpenTelemetry kunnen je enorm helpen in het beheersbaar houden van je data-pipelines.

Hybride architecturen zijn een andere trend. Niet alles hoeft direct event-driven te zijn. Vaak zie je combinaties waarin event streams worden opgeslagen in een data lake (zoals Delta Lake of Iceberg), zodat analisten batchgewijs kunnen blijven werken met de nieuwste data. Tegelijkertijd kunnen andere processen gebruikmaken van dezelfde events voor realtime analytics.

Conclusie: van reageren op tijd naar reageren op realiteit

De transitie van tijd gebaseerde naar event-driven data-architecturen is een logische stap in een wereld die steeds sneller en complexer wordt. Voor organisaties betekent het sneller inspelen op klantgedrag, slimmere processen en robuustere systemen. Voor data professionals betekent het nieuwe tools, nieuwe denkwijzen en een nieuwe leercurve.

Maar wie die curve aandurft, plukt snel de vruchten: wendbare data-infrastructuren die niet langer leven op de klok, maar op de polsslag van de werkelijkheid. Of, om het met een knipoog te zeggen: “In een wereld waar elke seconde telt, is wachten op middernacht ouderwets”.