Waarom data migratie testen zo kritisch (en lastig) is

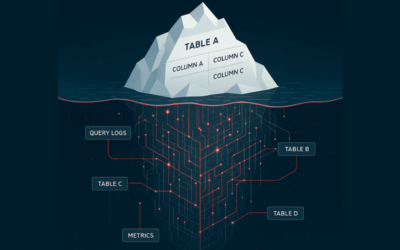

Een datamigratie is in principe een grote kopieeractie. Maar anders dan een simpele copy-paste in je bestandsbeheer, zijn de datasets vaak groot, complex en dynamisch. Denk aan historische datasets van miljoenen rijen, relationele structuren over tientallen tabellen, of transformatielogica die tussen systemen verschilt. Voeg daaraan toe dat bronsystemen soms nog in productie zijn tijdens de migratie (en dus blijven veranderen), of dat datatypes niet één-op-één overeenkomen. De kans op fouten ligt op de loer.

En dan is er nog iets: de verwachte uitkomst van een migratie is meestal “geen verschil”. Maar dat maakt het testen niet makkelijker. Je moet dus aantonen dat niets veranderd is, of alleen dat wat expliciet gewenst was. Dat vraagt om een andere manier van denken dan bij het testen van nieuwe functionaliteit.

Validatiestrategieën: van row counts tot checksums

Laten we eens kijken naar de tools in de gereedschapskist van een data engineer. Hoe test je dat de gemigreerde data klopt? Er zijn verschillende lagen waarop je kunt valideren, en het loont om die gelaagd aan te pakken.

Een veelgebruikte eerste stap is het vergelijken van row counts per tabel. Het is simpel en snel te automatiseren, en geeft een goede eerste sanity check: als je bron 80 miljoen rijen heeft en je doel ook, dan is dat alvast geruststellend. Maar het zegt natuurlijk niets over de inhoud. Daarom komt daarna vaak kolom-voor-kolom vergelijking in beeld. Tools als dbt, Great Expectations, Deequ of custom Python scripts kunnen rijen uit de bron en het doel vergelijken. Checksums per rij zijn hier handig: je maakt bijvoorbeeld een SHA-256 hash van alle relevante kolomwaarden, en vergelijkt die tussen bron en doel. Als de hash verschilt, is er ergens iets mis.

Een stap verder is het uitvoeren van inhoudelijke validaties: business rules die in de data moeten gelden. Denk aan: ‘het totaal van kolom A moet gelijk zijn aan het totaal van kolom B, of ‘er mogen geen negatieve bedragen voorkomen in kolom C’. Zulke regels zijn essentieel om ook semantische fouten op te sporen, bijvoorbeeld wanneer een valutaconversie verkeerd is gegaan.

Tot slot kun je ook steekproeven inzetten. Soms is het simpelweg niet haalbaar om alles te vergelijken. In dat geval kan een representatieve sample veel inzicht geven. Dit soort checks worden vaak handmatig gedaan door data analisten of business users, bijvoorbeeld via dashboards of gebruikersanalyses.

Typische valkuilen en hoe je ze omzeilt

Een veelvoorkomende fout is dat men pas na de migratie begint met testen. Je kunt echter veel eerder beginnen met het opzetten van teststrategieën, idealiter al tijdens de analysefase. Inventariseer welke datavelden complex zijn, welke tabellen kritisch zijn, en waar historische issues hebben gespeeld. Zet pilots of proefmigraties op en laat daar je testlogica op los. Zo voorkom je verrassingen op het eind.

Een andere valkuil is het overschatten van tools. Een tool als Great Expectations is krachtig, maar lost het probleem niet voor je op. Je moet zelf nog steeds goed nadenken over wat je wilt testen, waarom, en wat de acceptatiecriteria zijn. Technologie ondersteunt, maar de teststrategie komt uit je hoofd (en uit overleg met de business).

Ook belangrijk: vergeet de context van je data niet. Een veelgemaakte fout is het vergelijken van bijvoorbeeld datums of bedragen zonder rekening te houden met timezoneconversies, precisieverschillen of defaultwaarden die per systeem verschillen. Data kan er op het eerste gezicht hetzelfde uitzien, maar onder de motorkap net anders worden geïnterpreteerd.

Trends en ontwikkelingen: automatisering en data contracts

Steeds meer organisaties zetten in op geautomatiseerde data tests als onderdeel van hun CI/CD pipelines. Bij elke nieuwe batch of release draait er automatisch een test-suite die validatiechecks uitvoert op gemigreerde of vernieuwde datasets. Tools als dbt zijn hierin leidend, zeker in combinatie met moderne data stacks rond Airflow, Fivetran en Snowflake.

Een opkomende trend is het gebruik van data contracts: expliciete afspraken tussen producers en consumers van data over structuur, semantiek en validaties. Dit maakt het makkelijker om vooraf al duidelijke testcriteria vast te leggen, en fouten vroeg te detecteren. Denk bijvoorbeeld aan een JSON-schema dat beschrijft wat een dataset moet bevatten, inclusief toegestane waarden en datatypes. Zo’n contract kan vervolgens automatisch gevalideerd worden tijdens de migratie.

Tot slot: testen is geen sluitpost, maar fundament

Een succesvolle datamigratie hangt niet alleen af van een goede technische uitvoering, maar van grondige, doordachte validatie. En dat vraagt om meer dan alleen een paar queries achteraf. Het vraagt om een strategie: een combinatie van kwantitatieve checks, inhoudelijke validaties, samenwerking met de business én slimme automatisering.

Door je teststrategie op te bouwen vanaf het begin van het migratietraject, voorkom je dure hersteloperaties achteraf. En misschien nog wel belangrijker: je bouwt vertrouwen op. In je data, in het nieuwe systeem, en in de mensen die ermee werken.

Data migreren is mensenwerk, maar testen maakt het betrouwbaar!