De opkomst van ‘Ops’: van software naar data

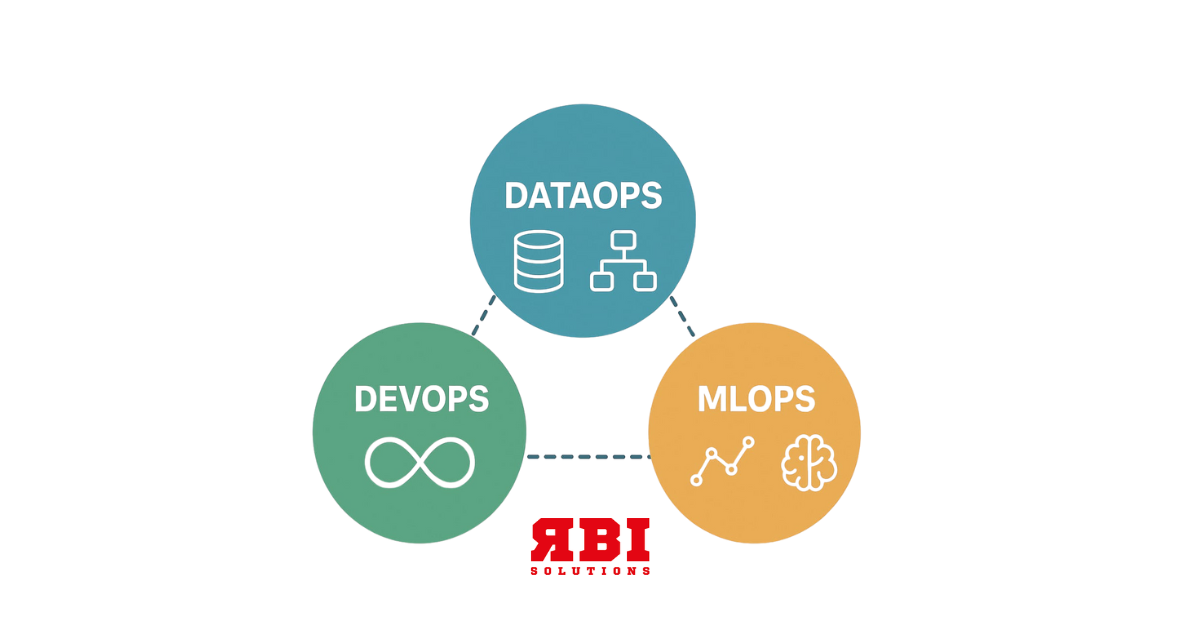

Het begon allemaal met DevOps, een samentrekking van “Development” en “Operations”. DevOps ontstond als antwoord op de logge manier waarop softwareontwikkeling en systeembeheer elkaar in het verleden vaak tegenwerkten. Door samenwerking, automatisering en continue integratie te bevorderen, werd software sneller, betrouwbaarder en beter schaalbaar geleverd. DevOps legde de basis voor een cultuur van eigenaarschap, snelle iteratie en constante verbetering, met minder rol en rechtenscheiding.

DataOps bouwt voort op die principes, maar richt zich specifiek op de dataketen: het verzamelen, verwerken en beheren van data. In plaats van applicatiecode, draait het hier om datastromen, datakwaliteit en governance. Waar DevOps ontwikkelaars en IT-beheerders samenbrengt, doet DataOps hetzelfde voor data engineers, data scientists en analisten.

MLOps is weer een aparte categorie: het combineert de DevOps-mentaliteit met de unieke eisen van machine learning. Want waar traditionele software in principe stabiel is na release, blijven ML-modellen leren, evalueren en bijsturen. Dat betekent dat niet alleen code, maar ook data, features, hyperparameters en modelversies beheerd moeten worden, idealiter op een geautomatiseerde en reproduceerbare manier.

Waar zit het verschil in de praktijk?

Stel je een organisatie voor die een aanbevelingssysteem bouwt voor haar e-commerceplatform. De ontwikkelaars schrijven de applicatiecode, beheren de infrastructuur en zorgen dat alles draait via een DevOps-pijplijn. Tegelijkertijd werken data engineers aan het verzamelen en schonen van gebruikersdata, waarbij ze monitoring en validatie automatiseren via DataOps-principes. Als de data op orde is, trainen data scientists een machine learning-model dat wordt ingezet via een MLOps-gestuurde workflow. Hier zorgen ze voor versiebeheer, continue training, model monitoring en automatische hertraining bij modeldrift.

Hoewel de drie disciplines elkaar overlappen in tools en principes (CI/CD, automatisering, versiebeheer), hebben ze elk hun eigen focus. DevOps draait om software. DataOps om datakwaliteit en -betrouwbaarheid. MLOps om het beheer van modellen en het operationaliseren van machine learning.

Best practices en tools in elk domein

In de wereld van DevOps zijn tools als Jenkins, GitLab CI/CD en Terraform gemeengoed. Ze helpen bij het testen, bouwen en uitrollen van software. DataOps maakt gebruik van tools zoals Apache Airflow, dbt, databricks of snowflake om data pipelines betrouwbaar en controleerbaar te maken. Voor MLOps zijn er platforms als MLflow, Tecton, Kubeflow en SageMaker die modeltraining, experiment tracking en deployment ondersteunen.

Wat al deze werkwijzen gemeen hebben, is het streven naar reproduceerbaarheid, schaalbaarheid en automatisering. Maar de complexiteit verschilt. In MLOps, bijvoorbeeld, moet je niet alleen de code tracken, maar ook de exacte data waarop getraind is, de gebruikte featuresets, en zelfs de random seed waarmee het model is gestart. Dat maakt MLOps vaak het meest uitdagend van de drie.

Uitdagingen en trends

Een veelvoorkomende uitdaging in DataOps is de versnippering van data. Teams werken met verschillende bronnen, formaten en definities, wat samenwerking bemoeilijkt. Hier bieden data catalogs, data contracts en central governance oplossingen. In MLOps is model monitoring een heet hangijzer: hoe weet je of een model dat gisteren goed presteerde, vandaag nog steeds accuraat is? Tools die real-time model performance tracken, vaak met driftdetectie, zijn in opkomst.

Een opvallende trend daarbij is de convergentie van de drie disciplines. Steeds vaker zien we geïntegreerde platforms die DevOps-, DataOps- en MLOps-capaciteiten combineren. Denk aan Databricks of Azure ML, waar data-ingestie, modellering en deployment in één omgeving plaatsvinden. Toch blijft het belangrijk om de verschillen te begrijpen, zodat je per use case de juiste aanpak kiest.

Tot slot: één cultuur, drie toepassingen

DevOps, DataOps en MLOps zijn geen modetermen, maar fundamentele denkwijzen die de brug slaan tussen technische expertise en operationele efficiëntie. Ze dwingen teams om gestructureerd, transparant en schaalbaar te werken, of het nu gaat om software, data of machine learning.

Het verschil zit hem uiteindelijk in de focus, maar de onderliggende cultuur is gelijk: samenwerken, automatiseren en continu verbeteren. Begrijp je dat, dan weet je niet alleen wat het verschil is tussen DevOps, DataOps en MLOps, je weet ook wanneer je welk ‘Ops’-model moet toepassen. En voor alle ‘Ops’-modellen geldt altijd: door eigenaarschap en wendbaarheid is het mogelijk om sneller, beter en goedkopere data, modellen of inzichten te leveren.